聚类算法分析报告汇总

嵌入式方向工程设计实验报告

学院班级:130712

学生学号:13071219

学生姓名:杨阳

同作者:无

实验日期:2010年12月

聚类算法分析研究

1 实验环境以及所用到的主要软件

Windows Vista NetBeans6.5.1 Weka3.6

MATLAB R2009a

2 实验内容描述

聚类是对数据对象进行划分的一种过程,与分类不同的是,它所划分的类是未知的,故此,这是一个“无指导的学习” 过程,它倾向于数据的自然划分。其中聚类算法常见的有基于层次方法、基于划分方法、基于密度以及网格等方法。本文中对近年来聚类算法的研究现状与新进展进行归纳总结。一方面对近年来提出的较有代表性的聚类算法,从算法思想。关键技术和优缺点等方面进行分析概括;另一方面选择一些典型的聚类算法和一些知名的数据集,主要从正确率和运行效率两个方面进行模拟实验,并分别就同一种聚类算法、不同的数据集以及同一个数据集、不同的聚类算法的聚类情况进行对比分析。最后通过综合上述两方面信息给出聚类分析的研究热点、难点、不足和有待解决的一些问题等。

实验中主要选择了K 均值聚类算法、FCM 模糊聚类算法并以UCI Machine Learning Repository 网站下载的IRIS 和WINE 数据集为基础通过MATLAB 实现对上述算法的实验测试。然后以WINE 数据集在学习了解Weka 软件接口方面的基础后作聚类分析,使用最常见的K 均值(即K-means )聚类算法和FCM 模糊聚类算法。下面简单描述一下K 均值聚类的步骤。

K 均值算法首先随机的指定K 个类中心。然后:

(1)将每个实例分配到距它最近的类中心,得到K 个类;

(2)计分别计算各类中所有实例的均值,把它们作为各类新的类中心。 重复(1)和(2),直到K 个类中心的位置都固定,类的分配也固定。 在实验过程中通过利用Weka 软件中提供的simpleKmeans (也就是K 均值聚类算法对WINE 数据集进行聚类分析,更深刻的理解k 均值算法,并通过对实验结果进行观察分析,找出实验中所存在的问题。然后再在学习了解Weka 软件接口方面的基础上对Weka 软件进行一定的扩展以加入新的聚类算法来实现基于Weka 平台的聚类分析。

3 实验过程

3.1

K 均值聚类算法

3.1.1 K 均值聚类算法理论

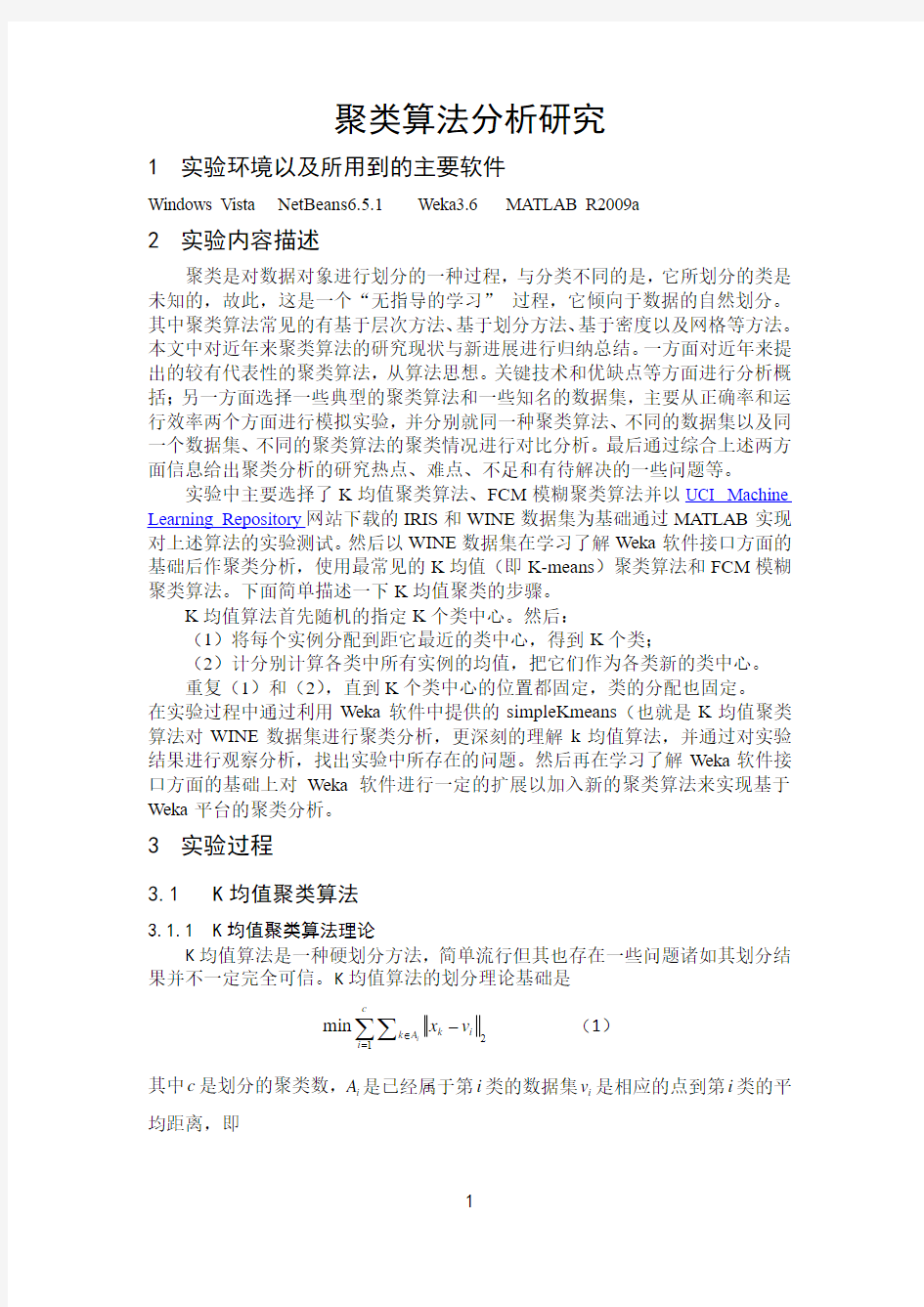

K 均值算法是一种硬划分方法,简单流行但其也存在一些问题诸如其划分结果并不一定完全可信。K 均值算法的划分理论基础是

2

1

min i

c

k i

k A i x v ∈=-∑∑ (1)

其中c 是划分的聚类数,i A 是已经属于第i 类的数据集i v 是相应的点到第i 类的平均距离,即

1

,i N k

k i k i i

x v x A N ==

∈∑

(2)

其中i N 表示在数据集i A 中的对象数。 3.1.2 算法的基本过程

1:step 任意选择K 个对象作为初始的类的中心; 2:step repeat ;

3:step 根据类中的平均值,将每个数据点 (重新)赋给最相近的类; 4:step 更新

类的平均值;

5:step until 不再发生变化,即没有对象进行被重新分配时过程结束。

3.1.3 算法代码分析

K 均值聚类算法的代码分析过程如下

首先调用clust_normalize ()函数将数据集标准化具体过程如下 data=clust_normalize(data,'range'); 下面是对K 均值算法的初始化 if max(size(param.c))==1, c = param.c;

index=randperm(N);

v=X(index(1:c),:);v = v + 1e-10;

v0=X(index(1:c)+1,:);v0 = v0 - 1e-10; else

v = param.c; c = size(param.c,1); index=randperm(N);

v0=X(index(1:c)+1,:);v0 = v0 + 1e-10; end iter = 0;

接着是迭代求解直到满足要求的解或者达到最大的迭代值 while prod(max(abs(v - v0))), iter = iter +1; v0 = v;

for i = 1:c

这里是用来计算欧氏距离

dist(:,i) = sum([(X - repmat(v(i,:),N,1)).^2],2); end

下面将分类结果赋值

[m,label] = min(dist');

distout=sqrt(dist);

下面计算分类中心

for i = 1:c

index=find(label == i);

if ~isempty(index)

v(i,:) = mean(X(index,:));

else

ind=round(rand*N-1);

v(i,:)=X(ind,:);

end

f0(index,i)=1;

end

J(iter) = sum(sum(f0.*dist));

if param.vis

clf

hold on

plot(v(:,1),v(:,2),'ro')

colors={'r.' 'gx' 'b+' 'ys' 'md' 'cv' 'k.' 'r*' 'g*' 'b*' 'y*' 'm*' 'c*' 'k*' };

for i=1:c

index = find(label == i);

if ~isempty(index)

dat=X(index,:);

plot(dat(:,1),dat(:,2),colors{i})

end

end

hold off

pause(0.1)

end

end

保存求解结果

result.cluster.v = v;

result.data.d = distout;

计算划分矩阵

f0=zeros(N,c);

for i=1:c

index=find(label == i);

f0(index,i)=1;

end

result.data.f=f0;

result.iter = iter;

result.cost = J;

3.1.4实验配置

实验过程配置比较简单只需按照如下介绍即可。

将路径修改为MATLAB工具箱的相应路径在次是

“E:\MATLAB\toolbox\FUZZCLUST”如下

path(path,'E:\MATLAB\toolbox\FUZZCLUST')

选择数据集在实验中选择了IRIS数据集,因此IRIS=1。在下面选择哪个数据集只需将相应的值置为1其他两个置为0。

wine=0;

iris=1;

wisc=0;

if wine

load winedat.txt

data=winedat(:,1:end-1);

C=winedat(:,end);

end

if iris

load iris

data=iris(:,1:4);

C=zeros(length(data),1);

for i=1:3

C(find(iris(:,4+i)==1))=i;

end

end

if wisc

wisc数据预处理

wisc=wk1read('wisconsin.wk1');

NI=9;

NT=length(wisc);

data.X=[wisc(:,11) wisc(:,2:10)];

data.X=sortrows(data.X,1);

[I,J]=find(data.X(:,7)~=0);

data.X=data.X(I,:);

[I,J]=find(data.X(:,1)==2);

data.X(I,1)=1;

[I,J]=find(data.X(:,1)==4);

data.X(I,1)=2;

C=data.X(:,1);

data=data.X(:,2:end);

end

数据标准化

data.X=data;

data=clust_normalize(data,'range');

下面的参数在FCM模糊聚类时用到

param.m=2;

如下参数是设置分类数即K=3

param.c=3;

param.val=1;

param.vis=0;

result=Kmeans(data,param);

result=validity(result,data,param);

[d1,d2]=max(result.data.f');

Cc=[];

for i=1:param.c

Ci=C(find(d2==i));

dum1=hist(Ci,1:param.c);

[dd1,dd2]=max(dum1);

Cc(i)=dd2;

end

3.1.5实验效果

实验中使用了UCI的IRIS数据集和WINE数据集,实验的结果如下图1)IRIS数据集实验结果

MATLAB实验输出的图形如下

图1 PCA图

图2 Conventional Sammon mapping 图

图3 Fuzzy Sammon mapping 图

并且可在实验中得到MATLAB的算法评价指标如下

2)WINE数据集实验结果

MATLAB实验输出的图形如下

图 4 PCA图

图 5 Conventional Sammon mapping 图

图 6 Fuzzy Sammon mapping 图

并且可在实验中得到MATLAB 的算法评价指标如下

将该算法在两种不同数据集中的测试结果对比如下

3.1.6 K 均值聚类算法的相关特点

该算法试图找出使平方误差值最小的K 个划分。当结果类是密集的,而类与类之间区分明显时,它的效果较好。

算法复杂度()o nkt ,其中t 是迭代次数。因此其可扩展性较好,对大数据集处理有较高的效率。

算法常以局部最优结束。全局最优要穷举所有可能的划分。

缺点:不适合发现非凸面状的类。不适合大小差别较大的类。对于噪声和孤立点是敏感的,由于少量的该类数据对平均值产生较大的影响。

3.2 FCM 模糊聚类算法

FCM 算法也是一种基于划分的聚类算法,它的思想就是使得被划分到同一类的对象之间相似度最大,而不同类之间的相似度最小。模糊C 均值算法是普通C 均值算法的改进,普通C 均值算法对于数据的划分是硬性的,而FCM 则是一种柔性的模糊划分。在介绍FCM 具体算法之前我们先介绍一些模糊集合的基本知识。

3.2.1 FCM 模糊聚类算法的理论 1) 理论基础-模糊集基本知识

首先说明隶属度函数的概念。隶属度函数是表示一个对象x 隶属于集合A 的程度的函数,通常记做()A x μ,其自变量范围是所有可能属于集合A 的对象(即集合A 所在空间中的所有点),取值范围是[]0,1,即()01A x μ≤≤。()1A x μ=表示x 完全隶属于集合A ,相当于传统集合概念上的x A ∈。一个定义在空间{}X x =上的隶属度函数就定义了一个模糊集合A ,

或者叫定义在论域{}X x =上的模糊子集。在聚类的问题中,可以把聚类生成的类看成模糊集合,因此每个样本点隶属于每个类的隶属度就是[]0,1区间里面的值。 2) FCM 的算法理论

1973年,Bezdek 提出了该算法,并作为早期硬C 均值聚类(HCM )方法的一种改进,命名为模糊C 均值聚类简称FCM 是一种目标函数法。假设将样本空间X 要分为k 个类,则类中心集123(,,,,)k C c c c c =使下式的目标函数值最小

2

11min n

k

m m ij

i j

i j J x c μ

===-∑∑ (3)

1

1k

ij

j μ

==∑ (4)

且有 [0,1]

1,2,,;1,2,,ij i n j k μ∈==

其中

()ij U μ=

被称为模糊隶属度矩阵。ij μ表示的是数据i x 隶属于类中心j c 的隶属度。m 是模糊加权参数,用于控制在模糊类间的程度依据参考的文献中一般取值为15。 应用拉格朗日乘法并基于上述约束可得到如下式

2

1

11

ij m c ij t tj D D μ-==?? ? ???

∑ (5) 且

1,1i c j N ≤≤≤≤

11

1N

m ij

j

j i N

m ij

j x C i c μ

μ

===

≤≤∑∑

(6)

其中ij D 是i X 到第j 类中心j C 的欧氏距离,即

i j X C -。

3.2.2 FCM 模糊聚类算法的过程

1:step 置初始化参数值,包含模糊加权参数值m 和聚类数k ,以及迭代的次

数s 和算法终止误差ε。

2:step 随机化置初始化聚类的中心0,0C t =。

3:step 计算隶属度矩阵U 可通过(5)式计算s U 得来。

4:step 依据(6)式迭代计算聚类的中心1s C +。

5:step 检验1s s U U ε+-<是否成立,成立则算法结束否则goto 3step 。

3.2.3 算法代码分析

FCM 聚类算法的代码分析过程如下 参数检查并初始化默认参数

if exist('param.m')==1, m = param.m;else m = 2;end; if exist('param.e')==1, e = param.m;else e = 1e-4;end; [N,n] = size(X);

[Nf0,nf0] = size(f0); X1 = ones(N,1);

初始化模糊划分矩阵 rand('state',0)

if max(Nf0,nf0) == 1, % only number of cluster given c = f0;

mm = mean(X); %mean of the data (1,n) aa = max(abs(X - ones(N,1)*mm)); %

v = 2*(ones(c,1)*aa).*(rand(c,n)-0.5) + ones(c,1)*mm; for j = 1 : c,

xv = X - X1*v(j,:);

d(:,j) = sum((xv*eye(n).*xv),2); end;

d = (d+1e-10).^(-1/(m-1));

f0 = (d ./ (sum(d,2)*ones(1,c))); else

c = size(f0,2);

fm = f0.^m; sumf = sum(fm); v = (fm'*X)./(sumf'*ones(1,n)); % end;

f = zeros(N,c); iter = 0; 该参数用来迭代计数 迭代求解直到满足实验要求的精度 while max(max(f0-f)) > e iter = iter + 1; f = f0;

下面计算分类中心 fm = f.^m;

sumf = sum(fm);

v = (fm'*X)./(sumf'*ones(1,n)); for j = 1 : c,

xv = X - X1*v(j,:);

d(:,j) = sum((xv*eye(n).*xv),2); end;

distout=sqrt(d);

J(iter) = sum(sum(f0.*d));

d = (d+1e-10).^(-1/(m-1));

f0 = (d ./ (sum(d,2)*ones(1,c)));

end

fm = f.^m;

sumf = sum(fm);

求解结果保存

result.data.f=f0;

result.data.d=distout;

result.cluster.v=v;

result.iter = iter;

result.cost = J;

3.2.4实验配置

实验配置过程与K均值算法的实验配置过程基本相同,只是在FCM模糊聚类算法实验中要用到模糊隶属度参数,一般将其设置在1~5之间在实验中设置如下param.m=2。也可以根据需要对其进行修改。

3.2.5实验效果

实验中使用了UCI的IRIS数据集和WINE数据集,实验的结果如下图

1)IRIS数据集实验结果

MATLAB实验输出的图形如下

图 7 PCA图

图 8 Conventional Sammon mapping 图

图 9 Fuzzy Sammon mapping 图

并且可在实验中得到MATLAB的算法评价指标如下

2)WINE数据集实验结果

MATLAB实验输出的图形如下

图40 PCA图

图 11 Conventional Sammon mapping 图

图 12 Fuzzy Sammon mapping 图

并且可在实验中得到MATLAB 的算法评价指标如下

将该算法在两种不同数据集中的测试结果对比如下

3.2.6 FCM 模糊聚类算法特点

FCM 算法需要两个参数一个是聚类数目c ,另一个是参数m 。一般来讲c 要远远小于聚类样本的总个数,同时要保证1c >。对于m ,它是一个控制算法的柔性的参数,如果m 过大,则聚类效果会很次,而如果m 过小则算法会接近K 均值聚类算法。算法的输出是c 个聚类中心点向量和*c N 的一个模糊划分矩阵,这个矩阵表示的是每个样本点属于每个类的隶属度。根据这个划分矩阵按照模糊集合中的最大隶属原则就能够确定每个样本点归为哪个类。聚类中心表示的是每个类的平均特征,可以认为是这个类的中心代表。

FCM 算法是图像分割使用最多的方法之一,它的成功主要归功于为解决每个图像像素的隶属需要引入了模糊性。与K 均值聚类相比较来说FCM 能够保留初始图像的更多信息。FCM 对孤立点和其他人造图像非常敏感。

3.3 算法评价

在算法的评价指标中选择指标PC 和CE 作为以上算法的评价指标。

PC-Partition Coefficient 用来测量在类之间的重复数量,其由Beadek 定义如下

()2

11

1

()c N

ij i j PC c N

μ===

∑∑

其中的ij μ是数据点j 在类i 中的隶属度系数。

CE-Classification Entropy 用来测量划分类的模糊度,与PC 有一定的相似性。其定义如下

11

1

()log(

)c N

ij

ij i j CE c N

μ

μ===-

∑∑

对于文中涉及到的K 均值聚类算法和FCM 模糊聚类算法在同一数据集中的实验对比如下

对于数据集IRIS 的对比如下表

表格7 IRIS 数据集下的评价指标对比

对于数据集WINE的对比如下表

有时也用所谓的文档关联来评测聚类方法。文档关联是指属于同一个类别的任意两个文档之间所形成的“文档对”关系。基于文档关联的聚类评测方法,其考察的基本对象就是“文档对”。这里的文档其实就是分类的数据对。

3.4基于weka的聚类分析

3.4.1数据的预处理

从网站下载的WINE原始数据集wine.data文件,而Weka软件需要的是ARFF 文件格式的数据。因此需要将数据转换成Weka支持的ARFF文件格式的。

转换过程如下

首先用记事本方式打开文件发现文件中的数据之间是以逗号来划分的,因此可以将数据文件的名称改为wine.csv。然后,打开Weka选择Tools选项下的ArffViewer如下图

打开ArffViewer后选择File选项下的Open弹出如下图的打开窗口,在文件类型一栏选择CSV data files(*.csv)项。

然后找到相应的文件后单击打开后如下图

接下来选择File选项下的Save as 后弹出如下图

在文件名栏输入相应的文件名后单击保存即可得到相应的arff格式的数据集文件。K均值算法只能处理数值型的属性,遇到分类型的属性时要把它变为若干个取值0和1的属性。WEKA将自动实施这个分类型到数值型的变换,而且WEKA会自动对数值型的数据作标准化。WEKA中的StringToWordVector过滤器能将ARFF文件中的文本数据转换为空间向量模型,它同时拥有分词、特征表示、特征提取等功能。在Explorer中的Reprocess界面导入ARFF文件,选择StringToWordVector过滤器,再设置相关参数。

3.4.2聚类过程

进入Explorer中的Preprocess 界面单击Open file后弹出如下图的数据集选择窗口,选择WINE.arff数据集文件后打开。

PAM聚类算法的分析与实现

毕业论文(设计)论文(设计)题目:PAM聚类算法的分析与实现 系别: 专业: 学号: 姓名: 指导教师: 时间:

毕业论文(设计)开题报告 系别:计算机与信息科学系专业:网络工程 学号姓名高华荣 论文(设计)题目PAM聚类算法的分析与实现 命题来源□√教师命题□学生自主命题□教师课题 选题意义(不少于300字): 随着计算机技术、网络技术的迅猛发展与广泛应用,人们面临着日益增多的业务数据,这些数据中往往隐含了大量的不易被人们察觉的宝贵信息,为了得到这些信息,人们想尽了一切办法。数据挖掘技术就是在这种状况下应运而生了。而聚类知识发现是数据挖掘中的一项重要的内容。 在日常生活、生产和科研工作中,经常要对被研究的对象经行分类。而聚类分析就是研究和处理给定对象的分类常用的数学方法。聚类就是将数据对象分组成多个簇,同一个簇中的对象之间具有较高的相似性,而不同簇中的对象具有较大的差异性。 在目前的许多聚类算法中,PAM算法的优势在于:PAM算法比较健壮,对“噪声”和孤立点数据不敏感;由它发现的族与测试数据的输入顺序无关;能够处理不同类型的数据点。 研究综述(前人的研究现状及进展情况,不少于600字): PAM(Partitioning Around Medoid,围绕中心点的划分)算法是是划分算法中一种很重要的算法,有时也称为k-中心点算法,是指用中心点来代表一个簇。PAM算法最早由Kaufman和Rousseevw提出,Medoid的意思就是位于中心位置的对象。PAM算法的目的是对n个数据对象给出k个划分。PAM算法的基本思想:PAM算法的目的是对成员集合D中的N个数据对象给出k个划分,形成k个簇,在每个簇中随机选取1个成员设置为中心点,然后在每一步中,对输入数据集中目前还不是中心点的成员根据其与中心点的相异度或者距离进行逐个比较,看是否可能成为中心点。用簇中的非中心点到簇的中心点的所有距离之和来度量聚类效果,其中成员总是被分配到离自身最近的簇中,以此来提高聚类的质量。 由于PAM算法对小数据集非常有效,但对大的数据集合没有良好的可伸缩性,就出现了结合PAM的CLARA(Cluster LARger Application)算法。CLARA是基于k-中心点类型的算法,能处理更大的数据集合。CLARA先抽取数据集合的多个样本,然后用PAM方法在抽取的样本中寻找最佳的k个中心点,返回最好的聚类结果作为输出。后来又出现了CLARNS(Cluster Larger Application based upon RANdomized

数据挖掘聚类算法课程设计报告

数据挖掘聚类问题(Plants Data Set)实验报告 1.数据源描述 1.1数据特征 本实验用到的是关于植物信息的数据集,其中包含了每一种植物(种类和科属)以及它们生长的地区。数据集中总共有68个地区,主要分布在美国和加拿大。一条数据(对应于文件中的一行)包含一种植物(或者某一科属)及其在上述68个地区中的分布情况。可以这样理解,该数据集中每一条数据包含两部分内容,如下图所示。 图1 数据格式 例如一条数据:abronia fragrans,az,co,ks,mt,ne,nm,nd,ok,sd,tx,ut,wa,wy。其中abronia fragrans是植物名称(abronia是科属,fragrans是名称),从az一直到wy 是该植物的分布区域,采用缩写形式表示,如az代表的是美国Arizona州。植物名称和分布地区用逗号隔开,各地区之间也用逗号隔开。 1.2任务要求 聚类。采用聚类算法根据某种特征对所给数据集进行聚类分析,对于聚类形成的簇要使得簇内数据对象之间的差异尽可能小,簇之间的差距尽可能大。 2.数据预处理 2.1数据清理 所给数据集中包含一些对聚类过程无用的冗余数据。数据集中全部数据的组织结构是:先给出某一科属的植物及其所有分布地区,然后给出该科属下的具体植物及其分布地区。例如: ①abelmoschus,ct,dc,fl,hi,il,ky,la,md,mi,ms,nc,sc,va,pr,vi ②abelmoschus esculentus,ct,dc,fl,il,ky,la,md,mi,ms,nc,sc,va,pr,vi ③abelmoschus moschatus,hi,pr 上述数据中第①行给出了所有属于abelmoschus这一科属的植物的分布地区,接下来的②③两行分别列出了属于abelmoschus科属的两种具体植物及其分布地区。从中可以看出后两行给出的所有地区的并集正是第一行给出的地区集

聚类分析K-means算法综述

聚类分析K-means算法综述 摘要:介绍K-means聚类算法的概念,初步了解算法的基本步骤,通过对算法缺点的分析,对算法已有的优化方法进行简单分析,以及对算法的应用领域、算法未来的研究方向及应用发展趋势作恰当的介绍。 关键词:K-means聚类算法基本步骤优化方法应用领域研究方向应用发展趋势 算法概述 K-means聚类算法是一种基于质心的划分方法,输入聚类个数k,以及包含n个数据对象的数据库,输出满足方差最小标准的k个聚类。 评定标准:同一聚类中的对象相似度较高;而不同聚类中的对象相似度较小。聚类相似度是利用各聚类中对象的均值所获得一个“中心对象”(引力中心)来进行计算。 解释:基于质心的划分方法就是将簇中的所有对象的平均值看做簇的质心,然后根据一个数据对象与簇质心的距离,再将该对象赋予最近的簇。 k-means 算法基本步骤 (1)从n个数据对象任意选择k 个对象作为初始聚类中心 (2)根据每个聚类对象的均值(中心对象),计算每个对象与这些中心对象的距离;并根据最小距离重新对相应对象进行划分 (3)重新计算每个(有变化)聚类的均值(中心对象) (4)计算标准测度函数,当满足一定条件,如函数收敛时,则算法终止;如果条件不满足则回到步骤(2) 形式化描述 输入:数据集D,划分簇的个数k 输出:k个簇的集合 (1)从数据集D中任意选择k个对象作为初始簇的中心; (2)Repeat (3)For数据集D中每个对象P do (4)计算对象P到k个簇中心的距离 (5)将对象P指派到与其最近(距离最短)的簇;

(6)End For (7)计算每个簇中对象的均值,作为新的簇的中心; (8)Until k个簇的簇中心不再发生变化 对算法已有优化方法的分析 (1)K-means算法中聚类个数K需要预先给定 这个K值的选定是非常难以估计的,很多时候,我们事先并不知道给定的数据集应该分成多少个类别才最合适,这也是K一means算法的一个不足"有的算法是通过类的自动合并和分裂得到较为合理的类型数目k,例如Is0DAIA算法"关于K一means算法中聚类数目K 值的确定,在文献中,根据了方差分析理论,应用混合F统计量来确定最佳分类数,并应用了模糊划分嫡来验证最佳分类数的正确性。在文献中,使用了一种结合全协方差矩阵RPCL算法,并逐步删除那些只包含少量训练数据的类。文献中针对“聚类的有效性问题”提出武汉理工大学硕士学位论文了一种新的有效性指标:V(k km) = Intra(k) + Inter(k) / Inter(k max),其中k max是可聚类的最大数目,目的是选择最佳聚类个数使得有效性指标达到最小。文献中使用的是一种称为次胜者受罚的竞争学习规则来自动决定类的适当数目"它的思想是:对每个输入而言不仅竞争获胜单元的权值被修正以适应输入值,而且对次胜单元采用惩罚的方法使之远离输入值。 (2)算法对初始值的选取依赖性极大以及算法常陷入局部极小解 不同的初始值,结果往往不同。K-means算法首先随机地选取k个点作为初始聚类种子,再利用迭代的重定位技术直到算法收敛。因此,初值的不同可能导致算法聚类效果的不稳定,并且,K-means算法常采用误差平方和准则函数作为聚类准则函数(目标函数)。目标函数往往存在很多个局部极小值,只有一个属于全局最小,由于算法每次开始选取的初始聚类中心落入非凸函数曲面的“位置”往往偏离全局最优解的搜索范围,因此通过迭代运算,目标函数常常达到局部最小,得不到全局最小。对于这个问题的解决,许多算法采用遗传算法(GA),例如文献中采用遗传算法GA进行初始化,以内部聚类准则作为评价指标。 (3)从K-means算法框架可以看出,该算法需要不断地进行样本分类调整,不断地计算调整后的新的聚类中心,因此当数据量非常大时,算法的时间开销是非常大 所以需要对算法的时间复杂度进行分析,改进提高算法应用范围。在文献中从该算法的时间复杂度进行分析考虑,通过一定的相似性准则来去掉聚类中心的候选集,而在文献中,使用的K-meanS算法是对样本数据进行聚类。无论是初始点的选择还是一次迭代完成时对数据的调整,都是建立在随机选取的样本数据的基础之上,这样可以提高算法的收敛速度。

实验三 K-均值聚类算法实验报告

实验三 K-Means聚类算法 一、实验目的 1) 加深对非监督学习的理解和认识 2) 掌握动态聚类方法K-Means 算法的设计方法 二、实验环境 1) 具有相关编程软件的PC机 三、实验原理 1) 非监督学习的理论基础 2) 动态聚类分析的思想和理论依据 3) 聚类算法的评价指标 四、算法思想 K-均值算法的主要思想是先在需要分类的数据中寻找K组数据作为初始聚类中心,然后计算其他数据距离这三个聚类中心的距离,将数据归入与其距离最近的聚类中心,之后再对这K个聚类的数据计算均值,作为新的聚类中心,继续以上步骤,直到新的聚类中心与上一次的聚类中心值相等时结束算法。 实验代码 function km(k,A)%函数名里不要出现“-” warning off [n,p]=size(A);%输入数据有n个样本,p个属性 cid=ones(k,p+1);%聚类中心组成k行p列的矩阵,k表示第几类,p是属性 %A(:,p+1)=100; A(:,p+1)=0; for i=1:k %cid(i,:)=A(i,:); %直接取前三个元祖作为聚类中心 m=i*floor(n/k)-floor(rand(1,1)*(n/k)) cid(i,:)=A(m,:); cid; end Asum=0; Csum2=NaN; flags=1; times=1; while flags flags=0; times=times+1; %计算每个向量到聚类中心的欧氏距离 for i=1:n

for j=1:k dist(i,j)=sqrt(sum((A(i,:)-cid(j,:)).^2));%欧氏距离 end %A(i,p+1)=min(dist(i,:));%与中心的最小距离 [x,y]=find(dist(i,:)==min(dist(i,:))); [c,d]=size(find(y==A(i,p+1))); if c==0 %说明聚类中心变了 flags=flags+1; A(i,p+1)=y(1,1); else continue; end end i flags for j=1:k Asum=0; [r,c]=find(A(:,p+1)==j); cid(j,:)=mean(A(r,:),1); for m=1:length(r) Asum=Asum+sqrt(sum((A(r(m),:)-cid(j,:)).^2)); end Csum(1,j)=Asum; end sum(Csum(1,:)) %if sum(Csum(1,:))>Csum2 % break; %end Csum2=sum(Csum(1,:)); Csum; cid; %得到新的聚类中心 end times display('A矩阵,最后一列是所属类别'); A for j=1:k [a,b]=size(find(A(:,p+1)==j)); numK(j)=a; end numK times xlswrite('data.xls',A);

聚类分析算法解析.doc

聚类分析算法解析 一、不相似矩阵计算 1.加载数据 data(iris) str(iris) 分类分析是无指导的分类,所以删除数据中的原分类变量。 iris$Species<-NULL 2. 不相似矩阵计算 不相似矩阵计算,也就是距离矩阵计算,在R中采用dist()函数,或者cluster包中的daisy()函数。dist()函数的基本形式是 dist(x, method = "euclidean", diag = FALSE, upper = FALSE, p = 2) 其中x是数据框(数据集),而方法可以指定为欧式距离"euclidean", 最大距离"maximum", 绝对值距离"manhattan", "canberra", 二进制距离非对称"binary" 和明氏距离"minkowski"。默认是计算欧式距离,所有的属性必须是相同的类型。比如都是连续类型,或者都是二值类型。 dd<-dist(iris) str(dd) 距离矩阵可以使用as.matrix()函数转化了矩阵的形式,方便显示。Iris数据共150例样本间距离矩阵为150行列的方阵。下面显示了1~5号样本间的欧式距离。 dd<-as.matrix(dd)

二、用hclust()进行谱系聚类法(层次聚类) 1.聚类函数 R中自带的聚类函数是hclust(),为谱系聚类法。基本的函数指令是 结果对象 <- hclust(距离对象, method=方法) hclust()可以使用的类间距离计算方法包含离差法"ward",最短距离法"single",最大距离法"complete",平均距离法"average","mcquitty",中位数法 "median" 和重心法"centroid"。下面采用平均距离法聚类。 hc <- hclust(dist(iris), method="ave") 2.聚类函数的结果 聚类结果对象包含很多聚类分析的结果,可以使用数据分量的方法列出相应的计算结果。 str(hc) 下面列出了聚类结果对象hc包含的merge和height结果值的前6个。其行编号表示聚类过程的步骤,X1,X2表示在该步合并的两类,该编号为负代表原始的样本序号,编号为正代表新合成的类;变量height表示合并时两类类间距离。比如第1步,合并的是样本102和143,其样本间距离是0.0,合并后的类则使用该步的步数编号代表,即样本-102和-143合并为1类。再如第6行表示样本11和49合并,该两个样本的类间距离是0.1,合并后的类称为6类。 head (hc$merge,hc$height)

各种聚类算法及改进算法的研究

论文关键词:数据挖掘;聚类算法;聚类分析论文摘要:该文详细阐述了数据挖掘领域的常用聚类算法及改进算法,并比较分析了其优缺点,提出了数据挖掘对聚类的典型要求,指出各自的特点,以便于人们更快、更容易地选择一种聚类算法解决特定问题和对聚类算法作进一步的研究。并给出了相应的算法评价标准、改进建议和聚类分析研究的热点、难点。上述工作将为聚类分析和数据挖掘等研究提供有益的参考。 1 引言随着经济社会和科学技术的高速发展,各行各业积累的数据量急剧增长,如何从海量的数据中提取有用的信息成为当务之急。聚类是将数据划分成群组的过程,即把数据对象分成多个类或簇,在同一个簇中的对象之间具有较高的相似度,而不同簇中的对象差别较大。它对未知数据的划分和分析起着非常有效的作用。通过聚类,能够识别密集和稀疏的区域,发现全局的分布模式,以及数据属性之间的相互关系等。为了找到效率高、通用性强的聚类方法人们从不同角度提出了许多种聚类算法,一般可分为基于层次的,基于划分的,基于密度的,基于网格的和基于模型的五大类。 2 数据挖掘对聚类算法的要求(1)可兼容性:要求聚类算法能够适应并处理属性不同类型的数据。(2)可伸缩性:要求聚类算法对大型数据集和小数据集都适用。(3)对用户专业知识要求最小化。(4)对数据类别簇的包容性:即聚类算法不仅能在用基本几何形式表达的数据上运行得很好,还要在以其他更高维度形式表现的数据上同样也能实现。(5)能有效识别并处理数据库的大量数据中普遍包含的异常值,空缺值或错误的不符合现实的数据。(6)聚类结果既要满足特定约束条件,又要具有良好聚类特性,且不丢失数据的真实信息。(7)可读性和可视性:能利用各种属性如颜色等以直观形式向用户显示数据挖掘的结果。(8)处理噪声数据的能力。(9)算法能否与输入顺序无关。 3 各种聚类算法介绍随着人们对数据挖掘的深入研究和了解,各种聚类算法的改进算法也相继提出,很多新算法在前人提出的算法中做了某些方面的提高和改进,且很多算法是有针对性地为特定的领域而设计。某些算法可能对某类数据在可行性、效率、精度或简单性上具有一定的优越性,但对其它类型的数据或在其他领域应用中则不一定还有优势。所以,我们必须清楚地了解各种算法的优缺点和应用范围,根据实际问题选择合适的算法。 3.1 基于层次的聚类算法基于层次的聚类算法对给定数据对象进行层次上的分解,可分为凝聚算法和分裂算法。 (1)自底向上的凝聚聚类方法。这种策略是以数据对象作为原子类,然后将这些原子类进行聚合。逐步聚合成越来越大的类,直到满足终止条件。凝聚算法的过程为:在初始时,每一个成员都组成一个单独的簇,在以后的迭代过程中,再把那些相互邻近的簇合并成一个簇,直到所有的成员组成一个簇为止。其时间和空间复杂性均为O(n2)。通过凝聚式的方法将两簇合并后,无法再将其分离到之前的状态。在凝聚聚类时,选择合适的类的个数和画出原始数据的图像很重要。 [!--empirenews.page--] (2)自顶向下分裂聚类方法。与凝聚法相反,该法先将所有对象置于一个簇中,然后逐渐细分为越来越小的簇,直到每个对象自成一簇,或者达到了某个终结条件。其主要思想是将那些成员之间不是非常紧密的簇进行分裂。跟凝聚式方法的方向相反,从一个簇出发,一步一步细化。它的优点在于研究者可以把注意力集中在数据的结构上面。一般情况下不使用分裂型方法,因为在较高的层很难进行正确的拆分。 3.2 基于密度的聚类算法很多算法都使用距离来描述数据之间的相似性,但对于非凸数据集,只用距离来描述是不够的。此时可用密度来取代距离描述相似性,即基于密度的聚类算法。它不是基于各种各样的距离,所以能克服基于距离的算法只能发现“类圆形”的聚类的缺点。其指导思想是:只要一个区域中的点的密度(对象或数据点的数目)大过某个阈值,就把它加到与之相近的聚类中去。该法从数据对象的分布密度出发,把密度足够大的区域连接起来,从而可发现任意形状的簇,并可用来过滤“噪声”数据。常见算法有DBSCAN,DENCLUE 等。[1][2][3]下一页 3.3 基于划分的聚类算法给定一个N个对象的元组或数据库,根据给定要创建的划分的数目k,将数据划分为k个组,每个组表示一个簇类(<=N)时满足如下两点:(1)每个组至少包含一个对象;(2)每个对

模糊聚类分析

目录 1引言: (3) 2 理论准备: (3) 2.1 模糊集合理论 (3) 2.2模糊C均值聚类(FCM) (4) 2.3 加权模糊C均值聚类(WFCM) (4) 3 聚类分析实例 (5) 3.1数据准备 (5) 3.1.1数据表示 (5) 3.1.2数据预处理 (5) 3.1.3 确定聚类个数 (6) 3.2 借助clementine软件进行K-means聚类 (7) 3.2.1 样本在各类中集中程度 (8) 3.2.2 原始数据的分类结果 (8) 3.2.3结果分析 (9) 3.3模糊C均值聚类 (10) 3.3.1 数据集的模糊C划分 (10) 3.3.2 模糊C均值聚类的目标函数求解方法 (10) 3.3.3 MATLAB软件辅助求解参数设置 (11) 3.3.4符号表示 (11)

3.3.5代码实现过程 (11) 3.3.6 FCM聚类分析 (11) 3.4 WFCM算法 (14) 3.4.1 WFCM聚类结果展示 (14) 3.4.2样本归类 (16) 3.4.3归类代码实现 (16) 4.结论 (17) 5 参考文献 (18) 6 附录 (18)

模糊聚类与非模糊聚类比较分析 摘要: 聚类分析是根据样本间的相似度实现对样本的划分,属于无监督分类。传统的聚类分析是研究“非此即彼”的分类问题,分类结果样本属于哪一类很明确,而很多实际的分类问题常伴有模糊性,即它不仅仅是属于一个特定的类,而是“既此又彼”。因此为了探究模糊聚类与非模糊聚类之间聚类结果的差别,本文首先采用系统聚类方法对上市公司132支股票数据进行聚类,确定比较合理的聚类数目为11类,然后分别采用K-means聚类与模糊聚类方法对股票数据进行聚类分析,最终得出模糊聚类在本案例中比K-means聚类更符合实际。 关键字:模糊集合,K-means聚类,FCM聚类,WFCM聚类 1引言: 聚类分析是多元统计分析的方法之一,属于无监督分类,是根据样本集的内在结构,按照样本之间相似度进行划分,使得同类样本之间相似性尽可能大,不同类样本之间差异性尽可能大。传统的聚类分析属于硬化分,研究对象的性质是非此即彼的,然而,现实生活中大多数事物具有亦此亦彼的性质。因此传统的聚类分析方法往往不能很好的解决具有模糊性的聚类问题。为此,模糊集合理论开始被应用到分类领域,并取得不错成果。 本文的研究目的是通过对比传统聚类和模糊聚类的聚类结果,找出二者之间的不同之处,并说明两种聚类分析方法在实例中应用的优缺点。 2理论准备: 2.1 模糊集合理论 模糊集合定义:设U为论域,则称由如下实值函数μA:U→ [ 0,1 ],u →μ ( u )所确定的集合A 为U上的模糊集合,而称μA为模糊集合A 的隶A 属函数,μ A ( u)称为元素u 对于A 的隶属度。若μA(u) =1,则认为u完全属于A;若μA(u) =0,则认为u完全不属于A,模糊集合是经典集合的推广。

聚类算法总结

聚类算法的种类:

--------------------------------------------------------- 几种常用的聚类算法从可伸缩性、适合的数据类型、高维性(处理高维数据的能力)、异常数据的抗干扰度、聚类形状和算法效率6个方面进行了综合性能评价,评价结果如表1所示:

--------------------------------------------------------- 目前聚类分析研究的主要内容: 对聚类进行研究是数据挖掘中的一个热门方向,由于以上所介绍的聚类方法都 存在着某些缺点,因此近些年对于聚类分析的研究很多都专注于改进现有的聚 类方法或者是提出一种新的聚类方法。以下将对传统聚类方法中存在的问题以 及人们在这些问题上所做的努力做一个简单的总结: 1 从以上对传统的聚类分析方法所做的总结来看,不管是k-means方法,还是CURE方法,在进行聚类之前都需要用户事先确定要得到的聚类的数目。然而在 现实数据中,聚类的数目是未知的,通常要经过不断的实验来获得合适的聚类 数目,得到较好的聚类结果。 2 传统的聚类方法一般都是适合于某种情况的聚类,没有一种方法能够满足各 种情况下的聚类,比如BIRCH方法对于球状簇有很好的聚类性能,但是对于不 规则的聚类,则不能很好的工作;K-medoids方法不太受孤立点的影响,但是 其计算代价又很大。因此如何解决这个问题成为当前的一个研究热点,有学者 提出将不同的聚类思想进行融合以形成新的聚类算法,从而综合利用不同聚类 算法的优点,在一次聚类过程中综合利用多种聚类方法,能够有效的缓解这个 问题。 3 随着信息时代的到来,对大量的数据进行分析处理是一个很庞大的工作,这 就关系到一个计算效率的问题。有文献提出了一种基于最小生成树的聚类算法,该算法通过逐渐丢弃最长的边来实现聚类结果,当某条边的长度超过了某个阈值,那么更长边就不需要计算而直接丢弃,这样就极大地提高了计算效率,降 低了计算成本。 4 处理大规模数据和高维数据的能力有待于提高。目前许多聚类方法处理小规 模数据和低维数据时性能比较好,但是当数据规模增大,维度升高时,性能就 会急剧下降,比如k-medoids方法处理小规模数据时性能很好,但是随着数据 量增多,效率就逐渐下降,而现实生活中的数据大部分又都属于规模比较大、 维度比较高的数据集。有文献提出了一种在高维空间挖掘映射聚类的方法PCKA (Projected Clustering based on the K-Means Algorithm),它从多个维度中选择属性相关的维度,去除不相关的维度,沿着相关维度进行聚类,以此对 高维数据进行聚类。 5 目前的许多算法都只是理论上的,经常处于某种假设之下,比如聚类能很好 的被分离,没有突出的孤立点等,但是现实数据通常是很复杂的,噪声很大, 因此如何有效的消除噪声的影响,提高处理现实数据的能力还有待进一步的提高。

对数据进行聚类分析实验报告

对数据进行聚类分析实验报告 1.方法背景 聚类分析又称群分析,是多元统计分析中研究样本或指标的一种主要的分类方法,在古老的分类学中,人们主要靠经验和专业知识,很少利用数学方法。随着生产技术和科学的发展,分类越来越细,以致有时仅凭经验和专业知识还不能进行确切分类,于是数学这个有用的工具逐渐被引进到分类学中,形成了数值分类学。近些年来,数理统计的多元分析方法有了迅速的发展,多元分析的技术自然被引用到分类学中,于是从数值分类学中逐渐的分离出聚类分析这个新的分支。结合了更为强大的数学工具的聚类分析方法已经越来越多应用到经济分析和社会工作分析中。在经济领域中,主要是根据影响国家、地区及至单个企业的经济效益、发展水平的各项指标进行聚类分析,然后很据分析结果进行综合评价,以便得出科学的结论。 2.基本要求 用FAMALE.TXT、MALE.TXT和/或test2.txt的数据作为本次实验使用的样本集,利用C均值和分级聚类方法对样本集进行聚类分析,对结果进行分析,从而加深对所学内容的理解和感性认识。 3.实验要求 (1)把FAMALE.TXT和MALE.TXT两个文件合并成一个,同时采用身高和体重数据作为特征,设类别数为2,利用C均值聚类方法对数据进行聚类,并将聚类结果表示在二维平面上。尝试不同初始值对此数据集是否会造成不同的结果。 (2)对1中的数据利用C均值聚类方法分别进行两类、三类、四类、五类聚类,画出聚类指标与类别数之间的关系曲线,探讨是否可以确定出合理的类别数目。 (3)对1中的数据利用分级聚类方法进行聚类,分析聚类结果,体会分级聚类方法。。(4)利用test2.txt数据或者把test2.txt的数据与上述1中的数据合并在一起,重复上述实验,考察结果是否有变化,对观察到的现象进行分析,写出体会 4.实验步骤及流程图 根据以上实验要求,本次试验我们将分为两组:一、首先对FEMALE 与MALE中数据组成的样本按照上面要求用C均值法进行聚类分析,然后对FEMALE、MALE、test2中数据组成的样本集用C均值法进行聚类分析,比较二者结果。二、将上述两个样本用分即聚类方法进行聚类,观察聚类结果。并将两种聚类结果进行比较。 (1)、C均值算法思想

数据挖掘中的聚类分析方法

计算机工程应用技术本栏目责任编辑:贾薇薇 数据挖掘中的聚类分析方法 黄利文 (泉州师范学院理工学院,福建泉州362000) 摘要:聚类分析是多元统计分析的重要方法之一,该方法在许多领域都有广泛的应用。本文首先对聚类的分类做简要的介绍,然后给出了常用的聚类分析方法的基本思想和优缺点,并对常用的聚类方法作比较分析,以便人们根据实际的问题选择合适的聚类方法。 关键词:聚类分析;数据挖掘 中图分类号:TP311文献标识码:A文章编号:1009-3044(2008)12-20564-02 ClusterAnlaysisMethodsofDataMining HUANGLi-wen (SchoolofScience,QuanzhouNormalUniversity,Quanzhou362000,China) Abstract:Clusteranalysisisoneoftheimportantmethodsofmultivariatestatisticalanalysis,andthismethodhasawiderangeofapplica-tionsinmanyfields.Inthispaper,theclassificationoftheclusterisintroducedbriefly,andthengivessomecommonmethodsofclusteranalysisandtheadvantagesanddisadvantagesofthesemethods,andtheseclusteringmethodwerecomparedandanslyzedsothatpeoplecanchosesuitableclusteringmethodsaccordingtotheactualissues. Keywords:ClusterAnalysis;DataMining 1引言 聚类分析是数据挖掘中的重要方法之一,它把一个没有类别标记的样本集按某种准则划分成若干个子类,使相似的样品尽可能归为一类,而不相似的样品尽量划分到不同的类中。目前,该方法已经被广泛地应用于生物、气候学、经济学和遥感等许多领域,其目的在于区别不同事物并认识事物间的相似性。因此,聚类分析的研究具有重要的意义。 本文主要介绍常用的一些聚类方法,并从聚类的可伸缩性、类的形状识别、抗“噪声”能力、处理高维能力和算法效率五个方面对其进行比较分析,以便人们根据实际的问题选择合适的聚类方法。 2聚类的分类 聚类分析给人们提供了丰富多彩的分类方法,这些方法大致可归纳为以下几种[1,2,3,4]:划分方法、层次方法、基于密度的聚类方法、基于网格的聚类方法和基于模型的聚类方法。 2.1划分法(partitiongingmethods) 给定一个含有n个对象(或元组)的数据库,采用一个划分方法构建数据的k个划分,每个划分表示一个聚簇,且k≤n。在聚类的过程中,需预先给定划分的数目k,并初始化k个划分,然后采用迭代的方法进行改进划分,使得在同一类中的对象之间尽可能地相似,而不同类的中的对象之间尽可能地相异。这种聚类方法适用于中小数据集,对大规模的数据集进行聚类时需要作进一步的改进。 2.2层次法(hietarchicalmethods) 层次法对给定数据对象集合按层次进行分解,分解的结果形成一颗以数据子集为节点的聚类树,它表明类与类之间的相互关系。根据层次分解是自低向上还是自顶向下,可分为凝聚聚类法和分解聚类法:凝聚聚类法的主要思想是将每个对象作为一个单独的一个类,然后相继地合并相近的对象和类,直到所有的类合并为一个,或者符合预先给定的终止条件;分裂聚类法的主要思想是将所有的对象置于一个簇中,在迭代的每一步中,一个簇被分裂为更小的簇,直到最终每个对象在单独的一个簇中,或者符合预先给定的终止条件。在层次聚类法中,当数据对象集很大,且划分的类别数较少时,其速度较快,但是,该方法常常有这样的缺点:一个步骤(合并或分裂)完成,它就不能被取消,也就是说,开始错分的对象,以后无法再改变,从而使错分的对象不断增加,影响聚类的精度,此外,其抗“噪声”的能力也较弱,但是若把层次聚类和其他的聚类技术集成,形成多阶段聚类,聚类的效果有很大的提高。2.3基于密度的方法(density-basedmethods) 该方法的主要思想是只要临近区域的密度(对象或数据点的数目)超过某个阈值,就继续聚类。也就是说,对于给定的每个数据点,在一个给定范围的区域中必须至少包含某个数目的点。这样的方法就可以用来滤处"噪声"孤立点数据,发现任意形状的簇。2.4基于网格的方法(grid-basedmethods) 这种方法是把对象空间量化为有限数目的单元,形成一个网格结构。所有的聚类操作都在这个网格结构上进行。用这种方法进行聚类处理速度很快,其处理时间独立于数据对象的数目,只与量化空间中每一维的单元数目有关。 2.5基于模型的方法(model-basedmethod) 基于模型的方法为每个簇假定一个模型,寻找数据对给定模型的最佳拟合。该方法经常基于这样的假设:数据是根据潜在的概 收稿日期:2008-02-17 作者简介:黄利文(1979-),男,助教。

模糊聚类分析应用

本科生毕业论文(设计) ( 2011 届) 论文(设计)题目模糊聚类分析应用 作者舒海波 系、专业理学分院数学与应用数学 班级应数072 指导教师(职称)何颖俞(讲师) 字数 9403 字 成果完成时间2011年4月10日 杭州师范大学钱江学院教学部制

模糊聚类分析应用 数学与应用数学专业0702班指导教师何颖俞 摘要:模糊聚类简单而言就是把数据中的指标分类。本文利用的是最大树法对等价矩阵进行聚类,然后利用fcm法对相似矩阵的求法进行比较。 关键字:模糊聚类,等价矩阵,最大树,相似矩阵 The application of fuzzy clustering Shuhaibo Instructor: HeYingYu Abstract: Fuzzy clustering is a method to classify the given data based on some indexes. In this paper I use the method of the maximal tree to classify the equivalent matrix, and then use clustering analysis method of FCM to comparison the solutions of the similar matrices. Key word: fuzzy clustering, equivalence matrix, the maximal tree, similar matrix

目录 1 绪论 (1) 2模糊聚类分析方法 (1) 2.1距离和相似系数 (1) 2.2 F相似关系 (2) 2.2.1定义 (2) 2.2.2 定理 (2) 2.3 聚类分析 (3) 2.3.1最大树法 (4) 3算法分类 (4) 3.1聚类方法的分类 (5) 3.1.1划分方法(partitioning method) (5) 3.1.2层次方法(hierarchical method) (5) 3.1.3基于密度的方法(density-based method) (5) 3.1.4基于网格的方法(grid-based method) (5) 3.1.5基于模型的方法(model-based method) (5) 3.2.数据挖掘领域中常用的聚类算法 (5) 3.2.1 CLARANS算法(随机搜索聚类算法) (5) 3.2.2 CURE算法(利用代表点聚类) (6) 3.2.3 BIRCH算法(利用层次方法的平衡迭代归约和聚类) (6) 3.2.4 DBSCAN算法(基于高密度连接区域的密度聚类方法) (6) 3.2.5 STING算法(统计信息风格) (7) 3.2.6 COBWEB算法(流行的简单增量概念聚类算法) (7) 3.2.6 模糊聚类算法FCM (8) 3.3 聚类算法的性能比较 (8) 4实际应用 (9) 5总结 (13) 参考文献: (13)

k均值聚类报告

K-均值聚类算法报告 摘要 K-均值是聚类方法中长用的一种划分方法,有很多优点,本文主要对K-均值是聚类方法的产生,工作原理,一般步骤,以及它的源码进行简单的介绍,了解K-均值是聚类!!! (一)课题名称:K-均值聚类(K-means clustering) (二)课题分析: J.B.MacQueen 在 1967 年提出的K-means算法[22]到目前为止用于科学和工业应用的诸多聚类算法中一种极有影响的技术。它是聚类方法中一个基本的划分方法,常常采用误差平方和准则函数作为聚类准则函数,误差平方和准则函数定义为: K-means 算法的特点——采用两阶段反复循环过程算法,结束的条件是不再有数据元素被重新分配: ① 指定聚类,即指定数据到某一个聚类,使得它与这个聚类中心的距离比它到其它聚类中心的距离要近。 ② 修改聚类中心。 优点:本算法确定的K 个划分到达平方误差最小。当聚类是密集的,且类与类之间区别明显时,效果较好。对于处理大数据集,这个算法是相对可伸缩和高效的,计算的复杂度为O(NKt),其中N是数据对象的数目,t是迭代的次数。一般来说,K< (1)从 n个数据对象任意选择 k 个对象作为初始聚类中心; (2)循环(3)到(4)直到每个聚类不再发生变化为止; (3)根据每个聚类对象的均值(中心对象),计算每个对象与这些中心对象的距离;并根据最小距离重新对相应对象进行划分; (4)重新计算每个(有变化)聚类的均值(中心对象) k-means 算法接受输入量 k ;然后将n个数据对象划分为 k个聚类以便使得所获得的聚类满足:同一聚类中的对象相似度较高;而不同聚类中的对象相似度较小。聚类相似度是利用各聚类中对象的均值所获得一个“中心对象”(引力中心)来进行计算的。 k-means 算法的工作过程说明如下:首先从n个数据对象任意选择 k 个对象作为初始聚类中心;而对于所剩下其它对象,则根据它们与这些聚类中心的相似度(距离),分别将它们分配给与其最相似的(聚类中心所代表的)聚类;然后再计算每个所获新聚类的聚类中心(该聚类中所有对象的均值);不断重复这一过程直到标准测度函数开始收敛为止。一般都采用均方差作为标准测度函数. k个聚类具有以下特点:各聚类本身尽可能的紧凑,而各聚类之间尽可能的分开。 (三)总体检索思路: 利用goole,百度,搜狗等搜索引擎及校内的一些数据库进行相关内容的检索。主要检索内容为K-均值聚类算法的工作原理,一般步骤,源码。 (四)检索过程记录: 关键词:K-均值聚类算法 搜索引擎:百度 检索内容:①K-均值聚类算法工作原理 ②K-均值聚类算法的一般步骤 ③K-均值聚类算法的源码 基于k—means聚类算法的试卷成绩分析研 究 第39卷第4期 2009年7月 河南大学(自然科学版) JournalofHenanUniversity(NaturalScience) V o1.39NO.4 Ju1.2009 基于k—means聚类算法的试卷成绩分析研究 谭庆' (洛阳师范学院信息技术学院,河南洛阳471022) 摘要:研究_rk-means聚类算法,并将此算法应用于高校学生试卷成绩分析中.首先对数据进行了预处理,然后 使用k-means算法,对学生试卷成绩进行分类评价.用所获得的结果指导学生的学习和今后的教学工作. 关键词:数据挖掘;聚类;k-means算法;试卷成绩 中圈分类号:TP311文献标志码:A文章编号:1003—4978(2009)04—0412—04 AnalysisandResearchofGradesofExaminationPaper BasedonK—meansClusteringAlgorithm TANQing (Acaderny.l,InformationTechnologY,LuoyangNormalUniversity,LuoyangHenan47102 2,China) Abstract:Thispaperresearcheslhekmeansclusteringalgorithmandappliesittotheanalysiso fthegradedataof examinationpaperofhighereducationschoolSstudents.Firstly,itpreprocessesthedatabefor eminingThen,it usesthek— 嵌入式方向工程设计实验报告 学院班级:130712 学生学号:13071219 学生姓名:杨阳 同作者:无 实验日期:2010年12月 聚类算法分析研究 1 实验环境以及所用到的主要软件 Windows Vista NetBeans6.5.1 Weka3.6 MATLAB R2009a 2 实验内容描述 聚类是对数据对象进行划分的一种过程,与分类不同的是,它所划分的类是未知的,故此,这是一个“无指导的学习” 过程,它倾向于数据的自然划分。其中聚类算法常见的有基于层次方法、基于划分方法、基于密度以及网格等方法。本文中对近年来聚类算法的研究现状与新进展进行归纳总结。一方面对近年来提出的较有代表性的聚类算法,从算法思想。关键技术和优缺点等方面进行分析概括;另一方面选择一些典型的聚类算法和一些知名的数据集,主要从正确率和运行效率两个方面进行模拟实验,并分别就同一种聚类算法、不同的数据集以及同一个数据集、不同的聚类算法的聚类情况进行对比分析。最后通过综合上述两方面信息给出聚类分析的研究热点、难点、不足和有待解决的一些问题等。 实验中主要选择了K 均值聚类算法、FCM 模糊聚类算法并以UCI Machine Learning Repository 网站下载的IRIS 和WINE 数据集为基础通过MATLAB 实现对上述算法的实验测试。然后以WINE 数据集在学习了解Weka 软件接口方面的基础后作聚类分析,使用最常见的K 均值(即K-means )聚类算法和FCM 模糊聚类算法。下面简单描述一下K 均值聚类的步骤。 K 均值算法首先随机的指定K 个类中心。然后: (1)将每个实例分配到距它最近的类中心,得到K 个类; (2)计分别计算各类中所有实例的均值,把它们作为各类新的类中心。 重复(1)和(2),直到K 个类中心的位置都固定,类的分配也固定。 在实验过程中通过利用Weka 软件中提供的simpleKmeans (也就是K 均值聚类算法对WINE 数据集进行聚类分析,更深刻的理解k 均值算法,并通过对实验结果进行观察分析,找出实验中所存在的问题。然后再在学习了解Weka 软件接口方面的基础上对Weka 软件进行一定的扩展以加入新的聚类算法来实现基于Weka 平台的聚类分析。 3 实验过程 3.1 K 均值聚类算法 3.1.1 K 均值聚类算法理论 K 均值算法是一种硬划分方法,简单流行但其也存在一些问题诸如其划分结果并不一定完全可信。K 均值算法的划分理论基础是 2 1 min i c k i k A i x v ∈=-∑∑ (1) 其中c 是划分的聚类数,i A 是已经属于第i 类的数据集i v 是相应的点到第i 类的平均距离,即 各种聚类算法的比较 聚类的目标是使同一类对象的相似度尽可能地小;不同类对象之间的相似度尽可能地大。目前聚类的方法很多,根据基本思想的不同,大致可以将聚类算法分为五大类:层次聚类算法、分割聚类算法、基于约束的聚类算法、机器学习中的聚类算法和用于高维度的聚类算法。摘自数据挖掘中的聚类分析研究综述这篇论文。 1、层次聚类算法 1.1聚合聚类 1.1.1相似度依据距离不同:Single-Link:最近距离、Complete-Link:最远距离、Average-Link:平均距离 1.1.2最具代表性算法 1)CURE算法 特点:固定数目有代表性的点共同代表类 优点:识别形状复杂,大小不一的聚类,过滤孤立点 2)ROCK算法 特点:对CURE算法的改进 优点:同上,并适用于类别属性的数据 3)CHAMELEON算法 特点:利用了动态建模技术 1.2分解聚类 1.3优缺点 优点:适用于任意形状和任意属性的数据集;灵活控制不同层次的聚类粒度,强聚类能力 缺点:大大延长了算法的执行时间,不能回溯处理 2、分割聚类算法 2.1基于密度的聚类 2.1.1特点 将密度足够大的相邻区域连接,能有效处理异常数据,主要用于对空间数据的聚类 1)DBSCAN:不断生长足够高密度的区域 2)DENCLUE:根据数据点在属性空间中的密度进行聚类,密度和网格与处理的结合 3)OPTICS、DBCLASD、CURD:均针对数据在空间中呈现的不同密度分不对DBSCAN作了改进 2.2基于网格的聚类 2.2.1特点 利用属性空间的多维网格数据结构,将空间划分为有限数目的单元以构成网格结构; 1)优点:处理时间与数据对象的数目无关,与数据的输入顺序无关,可以处理任意类型的数据 2)缺点:处理时间与每维空间所划分的单元数相关,一定程度上降低了聚类的质量和准确性 2.2.2典型算法 1)STING:基于网格多分辨率,将空间划分为方形单元,对应不同分辨率2)STING+:改进STING,用于处理动态进化的空间数据 3)CLIQUE:结合网格和密度聚类的思想,能处理大规模高维度数据4)WaveCluster:以信号处理思想为基础 2.3基于图论的聚类 2.3.1特点 转换为组合优化问题,并利用图论和相关启发式算法来解决,构造数据集的最小生成数,再逐步删除最长边 1)优点:不需要进行相似度的计算 2.3.2两个主要的应用形式 1)基于超图的划分 2)基于光谱的图划分 2.4基于平方误差的迭代重分配聚类 2.4.1思想 逐步对聚类结果进行优化、不断将目标数据集向各个聚类中心进行重新分配以获最优解基于k—means聚类算法的试卷成绩分析研究

聚类算法分析报告汇总

各种聚类算法的比较